728x90

Improving Transformer Backbone Design for Better Spotting

Self-Attention with Neighbor Awareness

- Self-attention within k Neighbors

- 가장 가까운 k개의 neighbor token들에대해서 attention 연산을 수행

- local feature를 사용하여 각 graphic entity들에대해 최적화할 수 있고 임의 크기의 CAD drawing에도 확장할 수 있음

- 최소 거리는 모든 entity들 간의 시작점과 끝점을 확인하여 계산

- model capacity를 향상시키기위해 nearest token 개수를 늘리는 것이 좋다고 하며 architecture에 있는 4개의 stage는 다음 stage에서 연산할 수록 neighborhood가 증가하고 receptive field가 커짐. (각 stage의 neighborhood 수는 $2^i$, i는 stage number) [Figure 3 (c) 참고]

- Multi-resolution Feature Fusion

- 서로 다른 scale을 가지는 이전 stage들의 feature 평균을 계산

- dense prediction task에서 효율성이 증명되었기 때문에 적용

- Graphic Entity Position Encoding

- trainable relative position bias를 적용

- 2D 좌표 상의 privitive의 중간 좌표를 기준

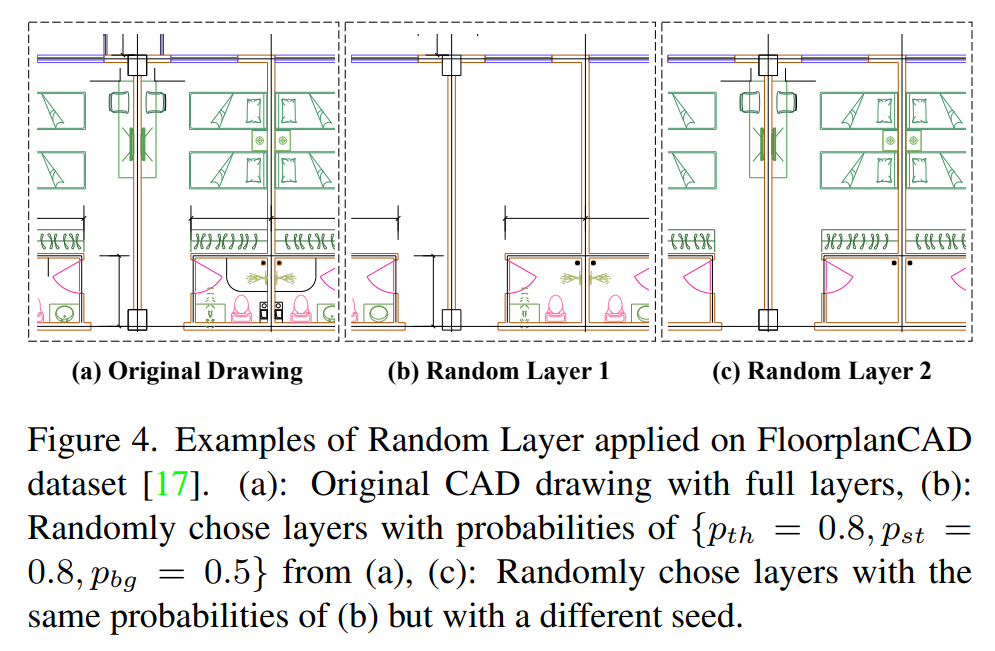

Random Layer Data Augmentation

구분된 layer들을 끄고 켬에 따라 서로 다른 drawing이 되어 새로운 data로써 사용된다. 이는 data hungry의 문제를 보완해준다.

마지막으로 해당 모델이 정말 필요성이 있는 것인지에 대한 의문이 있다. 건축 쪽을 전공하지는 않았지만 이미 CAD 프로그램 내에 있는 기능들을 활용하여 대체 할 수 있지 않을까하는 생각이 든다. introduction 부분에서 소개한 사용 목적 (occlusion, cluster, variation 등의 존재 확인)을 위해 연구하고 개발하는데 비용을 사용하는 것이 정말로 올바른 것일까?

728x90